조대협 (http://bcho.tistory.com)

본인은 구글 클라우드의 엔지니어이며, 이 글은 회사의 의견을 대표하지 않고 본인 개인의 의견임을 밝혀둡니다.

얼마전에 Gemini CLI가 발표되고, Google Gemini 서버가 폭주했다는 이야기까지 들려왔다.

사람들은 왜 Gemini CLI에 열광할까? 이미 ChatGPT나 Claude가 웹, 데스크탑 까지 지원하고 있고, Cursor나 Winsurf같은 코딩 AI에서 부터 Lovable, V0와 같은 바이브 코딩 툴이 있는데,

터미널에서 지원하는 CLI 기반의 AI가 나온것 하나가 이 시장에 어떤 영향을 미칠까?

무료 서비스라는 발표로 많은 인기를 얻었지만, 그 보다 Gemini CLI는 SDLC (Software Development Life Cycle)전체를 커버하는 Orchestrator로써의 포지션을 새롭게 정립하였고, 이로 인해서 앞으로 소프트웨어 개발 전체를 커버하려는 야심찬 계획을 엿볼 수 있다. 이 글에서는 Gemini CLI가 왜 인기가 있는지, 기능과 차별화점 그리고, Gemini CLI의 숨겨진 가치와 앞으로 발전 가능성에 대해서 이야기하고자 한다.

사람들이 Gemini CLI에 열광하는 이유

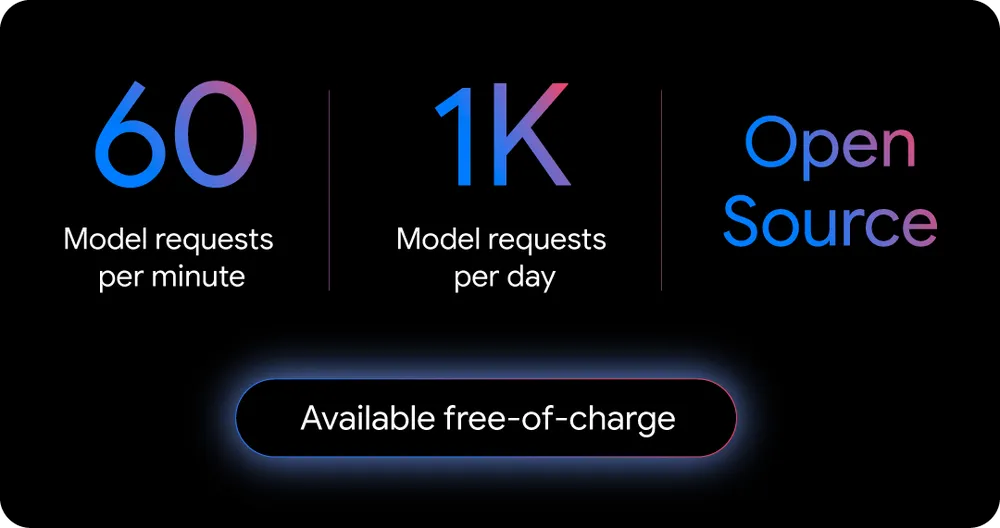

무엇보다 Gemini CLI에 사람들이 열광하는 이유는 그 성능과 가격에 있다. Gemini CLI는 당연히 유료티어가 있지만 무료 티어가 만만하지 않다. 초당 60개의 request를 보낼 수 있으며, 하루에 최대 1000개의 request를 보낼 수 있다.

Gemini CLI는 구글의 플래그십 모델인 Gemini 2.5 Pro 를 기반으로 하고 있다. Gemini 2.5 Pro는 Thinking Model로 모델이 답변을 내기전에 생각하는 과정을 거치기 때문에 상대적으로 응답시간이 늦는데, 보통 30~40초 구간의 응답 시간을 가지고 있다.이는 통상적인 사용자가 분당 1~2개 요청을 보낼 수 있다는 이야기인데, 분당 60 개의 요청을 처리하는 Free tier Limit에 비교하더라도, 분당 1~2개면 전혀 불편 없이 사용이 가능하다는 것이다. 또한 병렬로 처리를 한다고 해도, 충분한 양이고, 하루에 8시간 full로 gemini를 사용한다고 해도 (60분 * 분당 2회 * 8시간 = 960회)로 하루 8시간을 사용해도 충분한 Limit이다.

또한 다른 모델과는 다르게, Input window size가 1M token으로 chatgpt의 200K에 비해서 월등하게 크기 때문에, 코딩등의 유스케이스에서 많은 코드와 정보를 레퍼런스 할 수 있다는 장점을 가지고 있다.

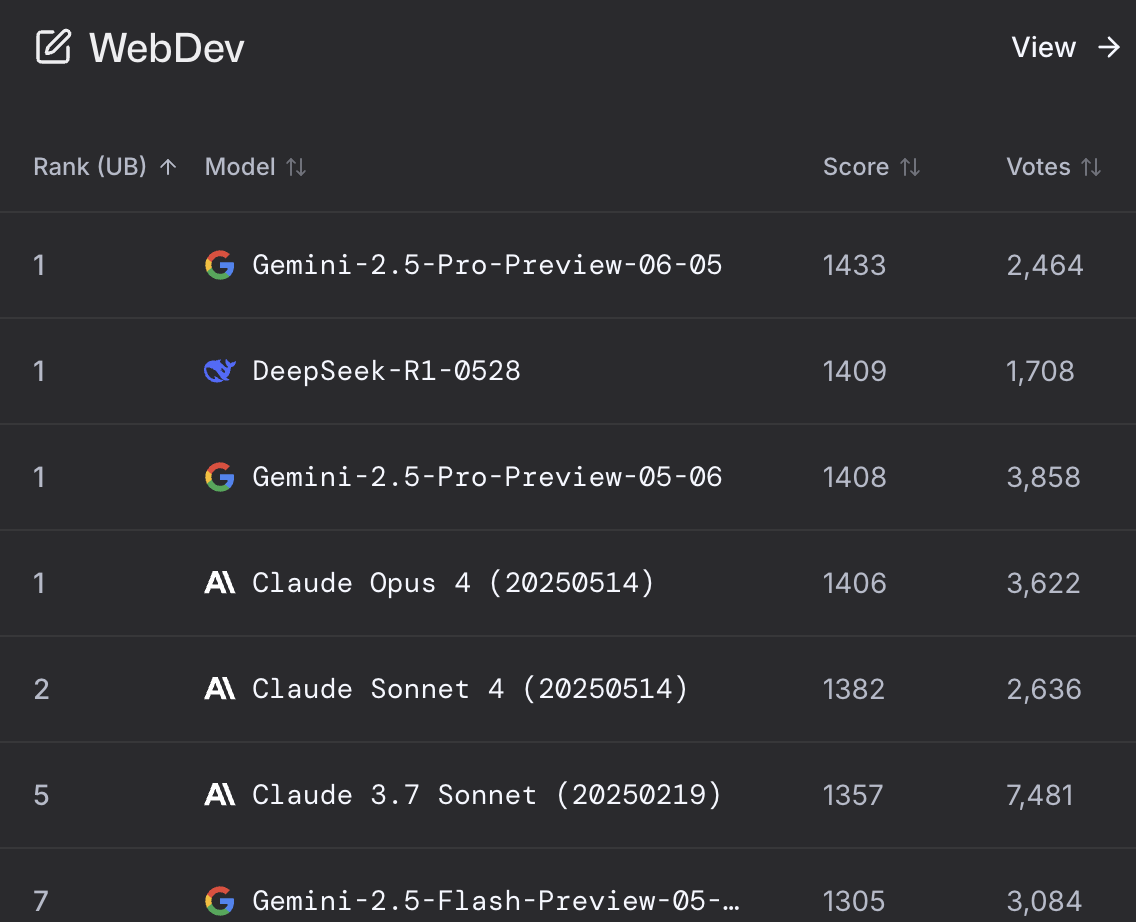

Gemini 2.5 Pro의 뛰어난 코딩 성능

Gemini CLI에 사용되는 모델은 2.5 Pro 모델로 현존하는 모델중에서는 lmarena.ai 기준으로 코딩 성능이 가장 높은 프리미엄 모델이다. 물론 lmarena.ai가 100% 신뢰할 수 있는 등급표는 아니고, 개발자들은 여전히 Anthropic 모델을 선호하고 있고, 실제 코딩에서는 Anthropic 모델의 성능이 높다는 이야기가 많기는 하지만, 그럼에도 불구하고 Gemini 2.5 Pro가 코딩에서 뛰어난 모델임은 사실이고, Anthropic의 월 subscription 비용이 최소 20%, Max plan의 경우 100~200$ 로 높은것에 비하면, 무료로 이정도 성능의 모델은 제공한다는 것은 매력적일 수 밖에 없다.

Code Assist 무료 AI IDE 추가 제공

여기에 더해서 Cursor AI / Windsurf AI와 같은 AI 기반의 IDE 툴인 Cloud Code Assits 역시 무료티어를 공개했는데, 기존의 Visual Studio나 Intelli J에 플러그인 형태로 인스톨하는 방식으로, 기존에 Cursor AI등을 사용하고 있으면, 여기에 추가로 Google Cloud Assist 를 설치해서 사용이 가능하다.

Gemini CLI의 특징

그러면 Gemini CLI에 기존의 도구에 비해서 제공하는 다른 경험은 무엇일까?

Local filesystem 연결

일단 API나 웹서비스가 아닌 CLI이기 때문에, 로컬 머신에서 실행이 되고, 이는 Gemini 모델이 Local 환경을 접근이 가능하다는 것이다. 즉 디스크에 있는 파일을 읽을 수 있으며, 로컬에 있는 명령어들을 모두 실행할 수 있게 된다. 이게 별것 아니라고 생각할 수 있지만, 아주 큰 가치를 갖는데, 예를 들어 내가 코딩을 할때 내 로컬 디렉토리에 있는 코드를 참고해서 코드를 생성하게 할 수 있고, 생성된 코드를 node.js, python 등을 이용해서 직접 실행하고, 테스트 코드등을 실행할 수 있도록 해준다. 즉 로컬 개발환경에 대한 풀 컨트롤과 자동화가 가능하게 된다는 이야기이다.

Sandbox 지원

AI agent에 대해서 Local file system에 접근을 허용할때, 가장 우려되는 부분이 보안에 대한 부분이다. 전체 디스크에 대한 access를 허용했을 경우에, agent의 확장 프로그램 (예를 들어 MCP server)가 악의적으로 내 개인정보를 탈취하거나, 내 컴퓨터의 설정을 임으로 변경할 수 있는 위험요소가 존재한다.

이를 방지하기 위해서, Gemini CLI는 Sandbox라는 기능을 지원하는데, 이 기능은 gemini가 실행되고 있는 디렉토리(하위 포함)만 파일 액세스를 가능하게 해주는 기능으로, agent가 원하지 않는 로컬 리소스에 대해 접근하는 것을 방지할 수 있다.

Google tool 지원

Gemini 모델이 다른 모델에 비해서, 차별화되는점 중의 하나가 Google Search 연동 기능이다. LLM은 특성상 학습된 데이터에 대해서만 답변을 할 수 있기 때문에, 최신 정보에 대한 답변을 할 수 없고 또한 학습된 내용이 맞는지 틀리는지에 대한 검증이 불가능하기 때문에, Hallucination (환상:LLM이 잘못된 답변을 내는 현상)이 발생할 가능성이 높다. Gemini는 built-in tool로 Google Search를 지원하는데, 만약에 LLM이 모르는 정보나, 최신정보 또는 사용자가 검색을 지시할 경우, 외부 Google Search를 통해서 검색을 하여, 그 정보를 참고할 수 있다.

MCP 지원

그리고 당연히 로컬 데스크탑에서 실행할 수 있는 도구이기 때문에, MCP를 지원한다. MCP에 대한 이야기는 워낙 정보가 많기 때문에 생략하기로 한다. 다음글에서 Gemini CLI와 Zapier MCP를 이용해서 한번에 5000+ 의 툴을 쉽게 연동할 수 있는 방법을 소개한다.

Gemini CLI가 궁극적으로 추구하고자 하는 가치

먼저 Gemini CLI가 추가적으로 제공할 수 있는 가치에 대해서 이해하려면, 기존 LLM 모델이나, API, Cursor와 같은 AI IDE 툴이 안되지만, CLI로 할 수 있는 것을 이해할 필요가 있다.

CLI는 Command로 다른 툴이 shell 명령어를 이용하여 호출할 수 있다. 또한 반대로 gemini CLI는 Local 환경에서 작동하기 때문에 다른 툴을 shell 명령어를 이용하여 호출하거나 또는 MCP를 통해서 다른툴을 호출할 수 있다.

Cursor와 같은 AI IDE툴은 사람이 앞에 앉아서 명령을 내리는 Interactive 환경으로 다른 도구에 의해서 AI IDE 기능을 호출할 수 없다. 또한 AI IDE는 MCP 등을 이용하여 다른 툴을 호출할 수 있지만 이 또한 사용자의 명령에 의해서 실행되는 것이지, 자동으로 실행하게 할 수 는 없다.

정리해서 이야기 하면, Gemini CLI는 다른 도구를 자동으로 (Cron등의 스케줄러에 의해서 )자유롭게 호출할 수 있고, 반대로 다른 툴에 의해서 자유롭게 호출될 수 있다.

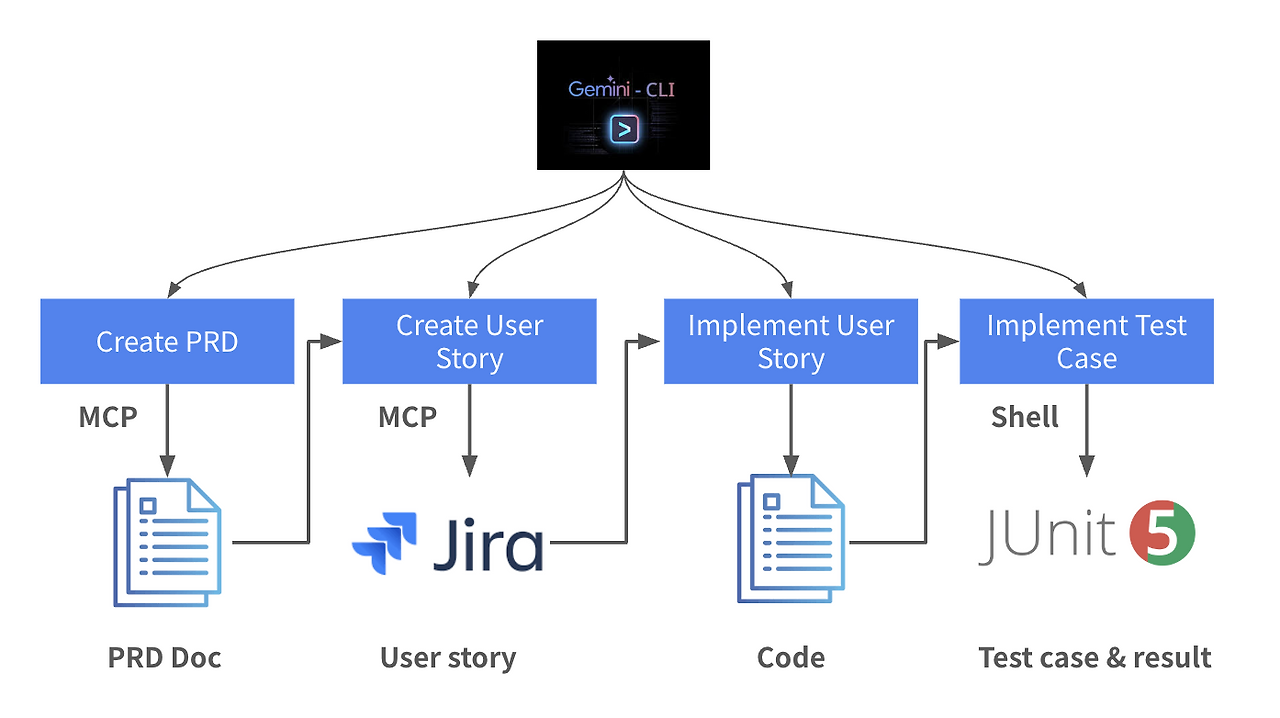

이해를 돕기 위해서 , 이를 실제 사용 시나리오로 예를 들어보면 다음과 같다.

- Gemini CLI를 사용하여, PRD (Product Requirement Document)를 생성하고 MCP 를 이용하여 Google Docs에 생성한다.

- Gemini CLI를 이용하여 생성된 PRD를 user story로 분류하여 MCP 를 통해서 JIRA로 등록하도록 한다.

- Gemini CLI를 통해서 JIRA에서 user story를 읽어서 user story 별로 코드를 생성하도록 한다.

- Gemini CLI를 통해서 로컬에 생성된 코드에 대해서 JUnit 테스트 케이스를 생성하고 테스트를 수행하도록 한다.

이 시나리오에서는 Gemini가 전체 SDLC (Software Development Life Cycle)을 아우르는 orchestrator로써 사용이 되었다. 단순한 CLI도구를 넘어서서 SDLC에 대한 Orchestrator로 포지셔닝을 하려는 전략을 엿볼 수 있다.

위의 케이스이외에도, Jenkins에 의해서 gemini cli를 호출하여 데이터를 정제 한다던지, argoCD를 통해서 배포 자동화를 수행한다는지와 같이, 코딩 이외에 소프트웨어 개발 라이프사이클 전반에 걸쳐서 사용될 수 있을것으로 예상된다.

가능성

Google이 이번에 Gemini CLI를 발표하면서 무료 티어를 발표해서 사용자층을 늘리는 전략으로 사용했다면, 다음은 Eco system을 생성하기 위해서 Gemini CLI를 오픈소스로 공개했다. 지금도 Shell command로 충분히 사용할 수 있지만, 더 나아가서 Jenkins/Argo CI/CD와 같은 도구들과 통합이 되거나, 특정 워크 플로우에 맞도록 코드를 수정할 수 있고, 더 많은 확장성을 제공하도록 할 수 있다.

Gemini CLI가 오픈소스와 무료정책에 힘입어서 활성화 되고, SDLC에 대한 전반적인 발전을 얼마나 가지고 올 수 있을지 지켜볼 일이다.

'빅데이타 & 머신러닝 > 생성형 AI (ChatGPT etc)' 카테고리의 다른 글

| Langgraph tool 호출 튜토리얼 (0) | 2025.07.07 |

|---|---|

| LLM 모델 알고리즘 이해를 기반으로, 효율적인 프롬프트 작성하기 (2) | 2025.07.06 |

| 잘알려지지 않은 Gemini의 유용한 기능 #2 - 구글 검색 연동과, 코드 실행 (7) | 2025.06.15 |

| 잘알려지지 않은 Gemini의 유용한 기능-#1 Thinking & Context URL (2) | 2025.06.03 |

| AI 개발 시대에서, 개발자로 살아남기 위해서.. (3) | 2025.05.21 |